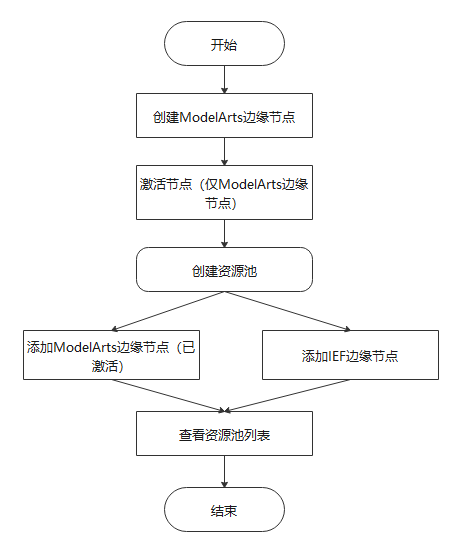

创建资源池之前,需要先激活ModelArts边缘节点或者纳管IEF边缘节点。边缘资源池创建完成后,您可以对资源池进行修改和删除操作,同时支持查看资源池详情信息。 创建边缘资源池 登录ModelArts管理控制台,在左侧菜单栏中选择“边缘资源…

创建边缘资源池之前先创建ModelArts边缘节点。ModelArts边缘节点基本信息完成后,下载证书和边缘Agent固件,并注册证书。您可以对边缘节点进行激活、修改、删除操作,同时支持查看边缘节点的详情信息。 创建边缘节点 登录Model…

当AI应用创建成功后,您可以进入AI应用详情页查看AI应用的信息。 登录ModelArts管理控制台,在左侧菜单栏中选择“AI应用管理 > AI应用”,进入“我的AI应用”列表页面。 单击目标AI应用名称,进入AI应用详情页面。 您可…

边缘资源池是边缘服务部署专用的资源池,是租户边缘侧的运行节点集合。推理服务在边缘池上运行,用户创建对应异步服务或边缘同步服务后,边缘服务会调度选择合适的节点运行异步算法容器,进行异步服务或边缘同步服务的处理。 节点 边缘节点是ModelAr…

“从模板中选择”功能即将下线。后续您可以通过“从对象存储服务(OBS)中选择”的AI引擎“Custom”模式,导入自定义引擎,来实现AI引擎和模型配置模板化的功能。 相同功能的模型配置信息重复率高,将相同功能的配置整合成一个通用的模板,通过…

在线服务的状态处于“运行中”,则表示在线服务已部署成功,部署成功的在线服务,将为用户提供一个可调用的API,此API为标准Restful API。在集成至生产环境之前,需要对此API进行调测。 在线服务的API默认为HTTPS访问,同时还支…

在AI应用管理创建AI应用时,如果是从OBS中导入元模型,则需要符合一定的模型包规范。 模型包规范适用于单模型场景,若是多模型场景(例如含有多个模型文件)推荐使用自定义镜像方式。 ModelArts推理平台不支持的AI引擎,推荐使用自定义镜…

TensorFlow存在两种接口类型,keras接口和tf接口,其训练和保存模型的代码存在差异,但是推理代码编写方式一致。 训练模型(keras接口) 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18…

本章节介绍了在ModelArts中模型推理代码编写的通用方法及说明,针对常用AI引擎的自定义脚本代码示例(包含推理代码示例),请参见自定义脚本代码示例。本文在编写说明下方提供了一个TensorFlow引擎的推理代码示例以及一个在推理脚本中自…

AI应用准备完成后,您可以将AI应用部署为在线服务,对在线服务进行预测和调用。 约束与限制 单个用户最多可创建20个在线服务。 前提条件 数据已完成准备:已在ModelArts中创建状态“正常”可用的AI应用。 由于在线运行需消耗资源,确保…