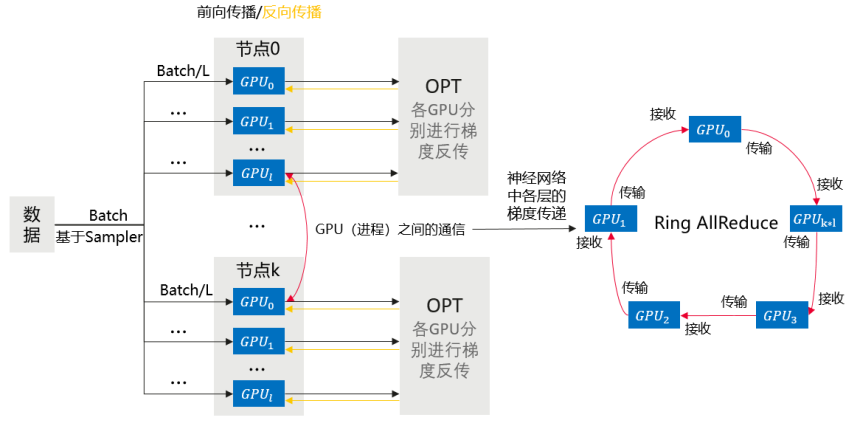

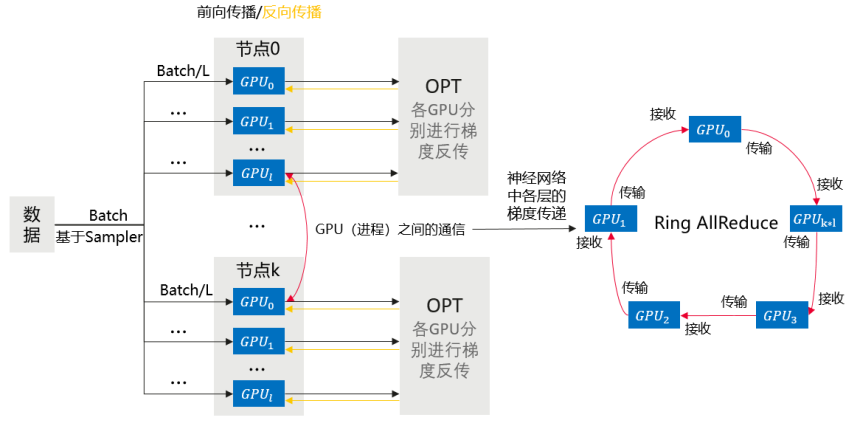

本章节介绍基于Pytorch引擎的多机多卡数据并行训练。 训练流程简述 相比于DP,DDP能够启动多进程进行运算,从而大幅度提升计算资源的利用率。可以基于torch.distributed实现真正的分布式计算,具体的原理此处不再赘述。大致的…

共8项

本章节介绍基于Pytorch引擎的多机多卡数据并行训练。 训练流程简述 相比于DP,DDP能够启动多进程进行运算,从而大幅度提升计算资源的利用率。可以基于torch.distributed实现真正的分布式计算,具体的原理此处不再赘述。大致的…

以下对resnet18在cifar10数据集上的分类任务,给出了分布式训练改造(DDP)的完整代码示例。 训练启动文件main.py内容如下(若需要执行单机单卡训练任务,则将分布式改造的代码删除): import datetime impo…

本文介绍三种使用训练作业来启动PyTorch DDP训练的方法及对应代码示例: 使用PyTorch预置框架功能,通过mp.spawn命令启动 使用自定义镜像功能 通过torch.distributed.launch命令启动 通过torch….

本文介绍了使用训练作业的自定义镜像+自定义启动命令来启动PyTorch DDP on Ascend加速卡训练。 前提条件 需要有Ascend加速卡资源池。 创建训练作业 本案例创建训练作业时,需要配置如下参数。 表1 创建训练作业的配置说明…

分布式训练功能介绍 单机多卡数据并行-DataParallel(DP) 多机多卡数据并行-DistributedDataParallel(DDP) 分布式调测适配及代码示例 分布式训练完整代码示例 基于训练作业启动PyTorch DDP训练…

本章节介绍基于Pytorch引擎的单机多卡数据并行训练。 MindSpore引擎的分布式训练参见MindSpore官网。 训练流程简述 单机多卡数据并行训练流程介绍如下: 将模型复制到多个GPU上 将一个Batch的数据均分到每一个GPU上…

在DistributedDataParallel中,不同进程分别从原始数据中加载batch的数据,最终将各个进程的梯度进行平均作为最终梯度,由于样本量更大,因此计算出的梯度更加可靠,可以适当增大学习率。 以下对resnet18在cifar1…

ModelArts提供了如下能力: 丰富的官方预置镜像,满足用户的需求。 支持基于预置镜像自定义制作专属开发环境,并保存使用。 丰富的教程,帮助用户快速适配分布式训练,使用分布式训练极大减少训练时间。 分布式训练调测的能力,可在PyChar…