MindSpore包含四种镜像:mindspore1.7.0-cuda10.1-py3.7-ubuntu18.04,mindspore1.7.0-py3.7-ubuntu18.04,mindspore1.2.0-cuda10.1-cudnn…

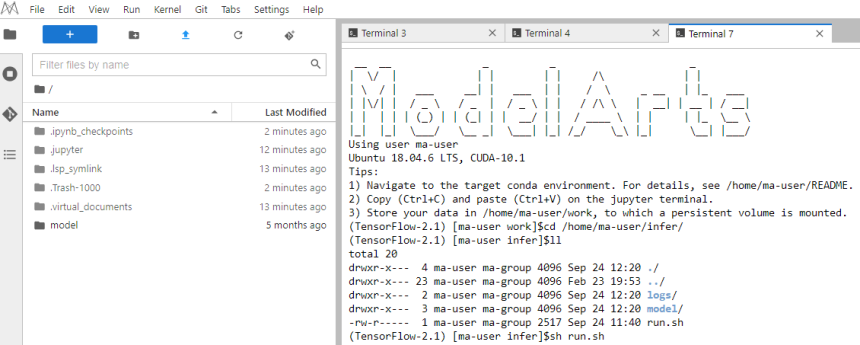

打开一个新的Terminal终端,进入“/home/ma-user/infer/”目录,运行启动脚本run.sh,并预测模型。基础镜像中默认提供了run.sh作为启动脚本。启动命令如下: sh run.sh 图1 运行启动脚本 上传一张预测…

本章节介绍如何从0到1制作镜像,并使用该镜像在ModelArts平台上进行训练。镜像中使用的AI引擎是Pytorch,训练使用的资源是CPU或GPU。 本实践教程仅适用于新版训练作业。 场景描述 本示例使用 Linux x86_64 架构的…

自定义镜像包含两种镜像:conda3-cuda10.2-cudnn7-ubuntu18.04,conda3-ubuntu18.04,该类镜像是无AI引擎以及相关的软件包,镜像较小,只有2~5G。用户使用此类镜像做基础镜像,安装自己需要的引擎…

前提条件 Notebook实例状态必须为“运行中”才可以一键进行镜像保存。 保存镜像 在Notebook列表中,对于要保存的Notebook实例,单击右侧“操作”列中的“更多 > 保存镜像”,进入“保存镜像”对话框。 图1 保存镜像 …

制作自定义镜像有以下方式: 方式一:使用Notebook的预置镜像创建开发环境实例,在环境中进行依赖安装与配置,配置完成后,可以通过开发环境提供的镜像保存功能,将运行实例的内容以容器镜像的方式保存下来,作为自定义镜像使用。详细操作请参考将N…

将Step2 在Notebook中调试模型的自定义镜像导入到AI应用中,并部署为在线服务。 登录ModelArts控制台,在左侧导航栏中选择“AI应用管理 > AI应用”,单击“创建”,进入创建AI应用。 设置AI应用的参数,如图1所…

准备一台具有Docker功能的机器,如果没有,建议申请一台弹性云服务器并购买弹性公网IP,并在准备好的机器上安装必要的软件。后续的构建、调试和注册操作都在此机器中进行。 ModelArts提供了ubuntu系统的脚本,方便安装docker、…

ModelArts的推理平台提供了一系列的基础镜像,用户可以基于这些基础镜像构建自定义镜像,用于部署推理服务。 X86架构(CPU/GPU)的推理基础镜像 表1 TensorFlow AI引擎版本 支持的运行环境 URI 2.1.0 CPU…

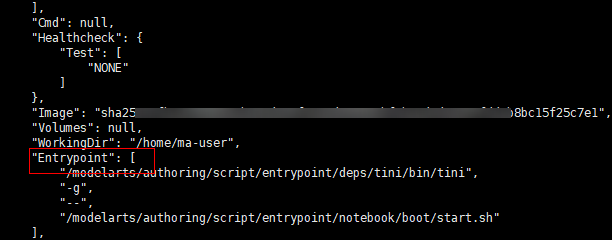

Notebook保存后的镜像有Entrypoint参数,如图1。Entrypoint参数中指定的可执行文件或命令会覆盖镜像的默认启动命令,Entrypoint中指定的执行命令内容不在镜像中预置,在本地环境通过docker run启动通过No…