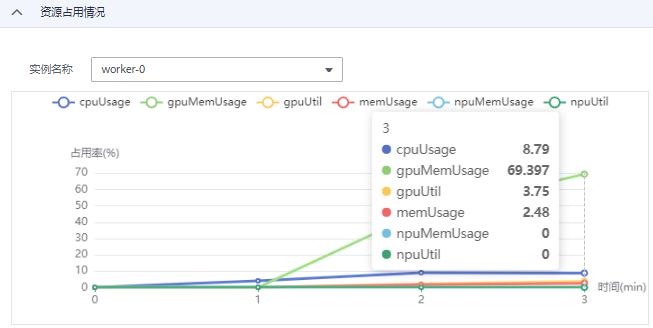

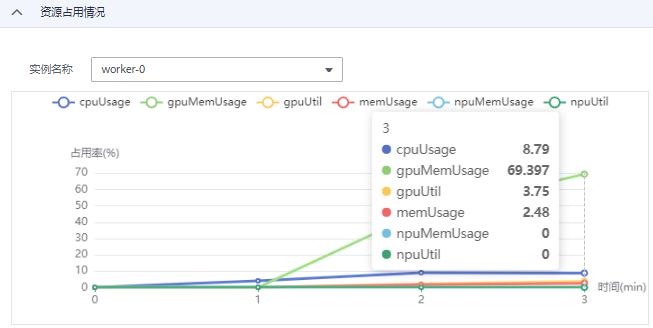

如何查看训练作业资源使用详情 用户可以通过资源占用情况窗口查看计算节点的资源使用情况,最多可显示最近三天的数据。在资源占用情况窗口打开时,会定期向后台获取最新的资源使用率数据并刷新。 操作一:如果训练作业使用多个计算节点,可以通过实例名称的…

AI开发平台ModelArts

如何查看训练作业资源使用详情 用户可以通过资源占用情况窗口查看计算节点的资源使用情况,最多可显示最近三天的数据。在资源占用情况窗口打开时,会定期向后台获取最新的资源使用率数据并刷新。 操作一:如果训练作业使用多个计算节点,可以通过实例名称的…

创建数据处理任务 管理和查看数据处理任务 同意关联代理商云淘科技,购买华为云产品更优惠(QQ 78315851) 内容没看懂? 不太想学习?想快速解决? 有偿解决: 联系专家

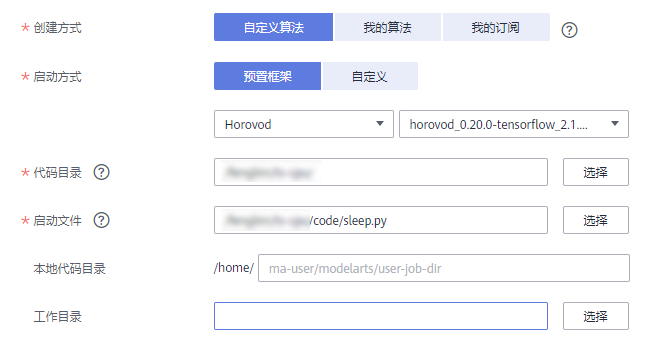

当您使用预置框架创建算法时,您需要提前完成算法的代码开发。本章详细介绍如何改造本地代码以适配ModelArts上的训练。 创建算法时,您需要在创建页面提供代码目录路径、代码目录路径中的启动文件、训练输入路径参数和训练输出路径参数。这四种输入…

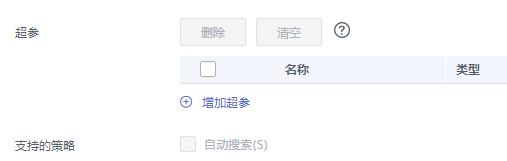

背景信息 对于用户希望优化的超参,需在“超参”设置中定义,可以给定名称、类型、默认值、约束等,具体设置方法可以参考定义超参。 如果用户使用的AI引擎为pytorch_1.8.0-cuda_10.2-py_3.7-ubuntu_18.04-x…

训练作业运行结束后,ModelArts可为您的模型进行评估,并且给出调优诊断和建议。 针对使用预置算法创建训练作业,无需任何配置,即可查看此评估结果(由于每个模型情况不同,系统将自动根据您的模型指标情况,给出一些调优建议,请仔细阅读界面中的…

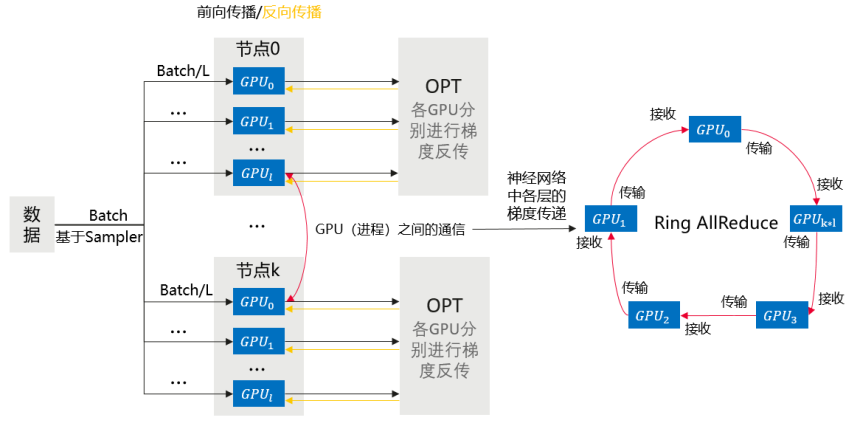

本章节介绍基于Pytorch引擎的多机多卡数据并行训练。 训练流程简述 相比于DP,DDP能够启动多进程进行运算,从而大幅度提升计算资源的利用率。可以基于torch.distributed实现真正的分布式计算,具体的原理此处不再赘述。大致的…

数据校验 数据清洗 数据选择 数据增强 同意关联代理商云淘科技,购买华为云产品更优惠(QQ 78315851) 内容没看懂? 不太想学习?想快速解决? 有偿解决: 联系专家

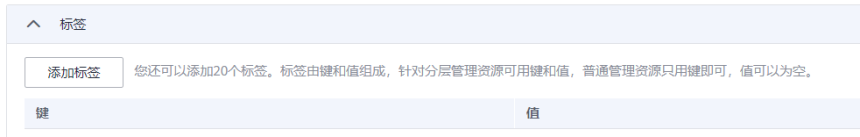

展示训练作业的标签。支持添加、修改、删除标签。标签详细用法请参见ModelArts如何通过标签实现资源分组管理。 图1 标签 父主题: 完成一次训练 同意关联代理商云淘科技,购买华为云产品更优惠(QQ 78315851) 内容没看懂? 不太…

删除数据处理任务 当已有的数据处理任务不再使用时,您可以删除数据处理任务。 处于“完成”、“失败”、“已停止”、“运行失败”、“部署中”状态的训练作业,您可以单击操作列的“删除”,删除对应的数据处理任务。 查看数据处理任务详情 登录Mode…

由于需要训练作业处于“运行中”状态才能登录CloudShell,因此本文介绍如何使训练作业保持运行中状态,方便您快速通过CloudShell登录运行中的训练容器。 通过Sleep命令使训练作业保持运行 如果你使用的是预置框架: 在Model…